인공지능(AI)의 인기가 절정으로 치달리고 있습니다. 그런 시점에 일부 인공지능 전문가들이 강력한 AI 시스템을 가능하게 하는 학습 데이터가 부족해질 수 있다고 경고하고 나섰습니다.

웹에 차고 넘치는 것이 데이터인데 왜 부족할 수도 있다는 주장이 나오는 것일까요? 정확하며 품질이 좋은 결과를 만드는 AI 알고리즘을 훈련하려면 많은 데이터가 필요합니다. 불충분한 양의 데이터로 알고리즘을 학습시키면 부정확하거나 품질이 낮은 결과물을 생성하게 됩니다.

ChatGPT는 570기가바이트의 텍스트 데이터, 즉 약 3,000억 개의 단어로 학습되었습니다. 어느 정도 분량인지 감이 안오시지요? 국어대사전에 실린 단어(표제어)가 50만개가 조금 넘는 수준이니 3,000억이라는 숫자의 크기가 상상이 되시지요?.

마찬가지로 미드저니, DALL-E와 같은 이미지 생성기의 기반이 되는 알고리즘인 스테이블 디퓨전은 58억 개의 이미지-텍스트 쌍으로 구성된 LIAON-5B 데이터 세트를 학습시켰습니다.

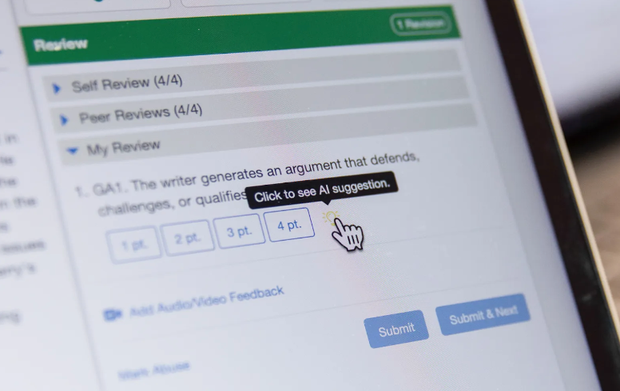

학습 데이터의 품질도 중요합니다. 소셜 미디어 게시물이나 흐릿한 사진과 같은 질이 낮은 데이터는 쉽게 구할 수 있지만 고성능 AI 모델을 학습시키기에는 충분하지 않습니다. 또, 소셜 미디어 플랫폼에서 가져온 텍스트는 편향되거나 편견이 있을 수 있으며 모델에 의해 복제될 수 있는 허위 정보나 불법 콘텐츠가 포함될 수 있습니다.

그렇기 때문에 AI 개발자는 책, 온라인 기사, 과학 논문, 위키피디아 및 필터링이 된 웹 콘텐츠의 텍스트와 같은 고품질 콘텐츠를 찾습니다. 구글 어시스턴트는 자연스러운 대화를 이어갈 수 있도록 셀프 퍼블리싱 사이트 스매쉬워즈(Smashwords)에서 11,000개의 로맨스 소설을 학습했습니다.

AI가 발전할수록 업계는 점점 더 방대한 데이터 세트로 학습시켜 왔으며, 그 덕분에 우리는 지금 ChatGPT나 DALL-E 3와 같은 놀라운 AI를 만나고 있습니다. 인공지능 시대는 이제 시작이고, 점점 더 많은 데이터가 필요해질 것입니다.

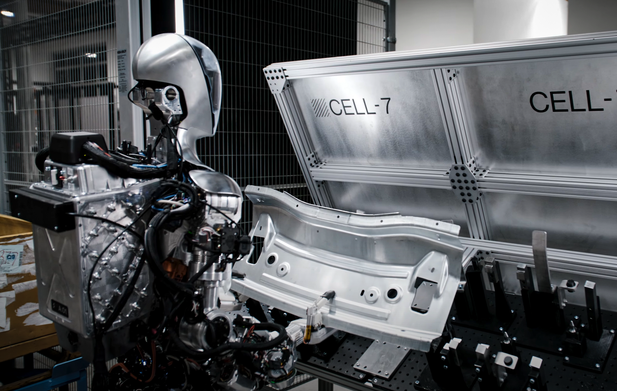

그런데 연구에 따르면 온라인 데이터 재고는 AI 학습에 사용되는 데이터 세트보다 훨씬 더 느리게 증가하고 있습니다. 작년에 발표된 한 논문에서 한 연구진은 현재의 AI 학습 추세가 지속된다면 2026년 이전에 고품질 텍스트 데이터가 고갈될 것이라고 예측했습니다. 또한 저품질 언어 데이터는 2030년에서 2050년 사이에, 저품질 이미지 데이터는 2030년에서 2060년 사이에 고갈될 것으로 예상했습니다.

이러한 학습데이터 부족은 현재 인공지능의 대세를 이루고 있는 대규모 언어모델의 성장에는 치명적인 악영향을 주고, 극단적으로는 AI 혁명의 궤도가 바뀔 수도 있습니다.

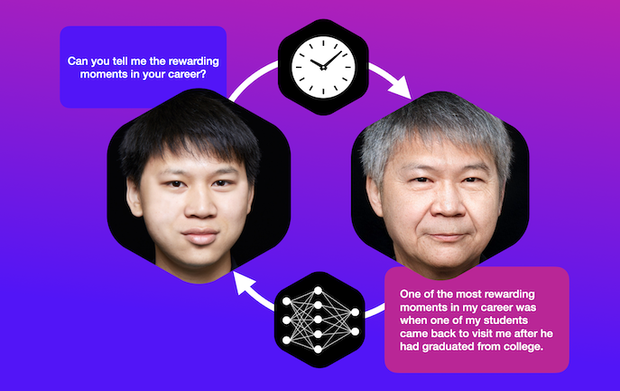

물론, 전문가들은 다양한 해결책을 모색하고 있습니다. 더 적은 데이터와 연산 능력으로 훈련시킬 수 있도록 알고리즘을 개선하고, 기존 데이터를 합성해서 새로운 데이터를 만들거나, 지금까지 인터넷에 올라오지 않은 오프라인 자료들을 디지털화하는 등의 노력을 하고 있습니다. 그렇지만, 결국은 어느 시점부터는 인공지능이 생성한 데이터로 인공지능을 학습하게 될 것입니다.

얼마 전에 대입 수능이 있었습니다. 초등학교부터 고등학교까지 교과서나 참고서 모두 합쳐도 2~3백권 남짓입니다. 그것도 힘들다고 ‘빼기’만 외치는 우리 모습과 ‘여전히 배고프다’를 외치는 인공지능! 함께 갈 수 있을까요?

![[번역] 오늘날의 생성 AI 문제점의 원인이 되고 있는 토큰](https://datacdn.soyo.or.kr/wcont/uploads/2024/07/12102439/%E1%84%90%E1%85%A9%E1%84%8F%E1%85%B3%E1%86%AB%E1%84%82%E1%85%A1%E1%84%8B%E1%85%B5%E1%84%8C%E1%85%A5_620.png)

![[번역] 점과 점 연결하기: AI가 웹을 먹어치우고 있다.](https://datacdn.soyo.or.kr/wcont/uploads/2024/07/06142422/%E1%84%82%E1%85%A6%E1%84%90%E1%85%B3%E1%84%8B%E1%85%AF%E1%84%8F%E1%85%B3_620.png)

![[번역] 디지털 시대의 언어 변화](https://datacdn.soyo.or.kr/wcont/uploads/2024/06/14103144/%E1%84%82%E1%85%A1_%E1%84%8B%E1%85%A5%E1%86%AB%E1%84%8B%E1%85%A5_620.png)

![[독서 3] ‘책 읽기’가 아니라 ‘읽기’부터](https://datacdn.soyo.or.kr/wcont/uploads/2024/06/14102017/%E1%84%80%E1%85%A1_1_620.jpg)

![[AI와 교육] 학습에 다양하게 챗봇을 활용하고 있는 미국의 중고등학생](https://datacdn.soyo.or.kr/wcont/uploads/2024/06/07152728/%E1%84%80%E1%85%A3%E1%86%BC_0.png)

댓글을 남겨주세요

댓글을 남기려면 로그인 해야 합니다.