친구추가 하시면 매일 ‘오늘의 글’을 받아보실수 있습니다.

[협동조합 소요] 조합에 가입하기

조합원이 되시면 더 많은 자료와 정보

교육을 함께 하실 수 있습니다.

소요 사이트는 어떤 곳일까요?

다양하고 유익한 소요의 콘텐츠와

활용법을 알려드립니다.

오늘의 글

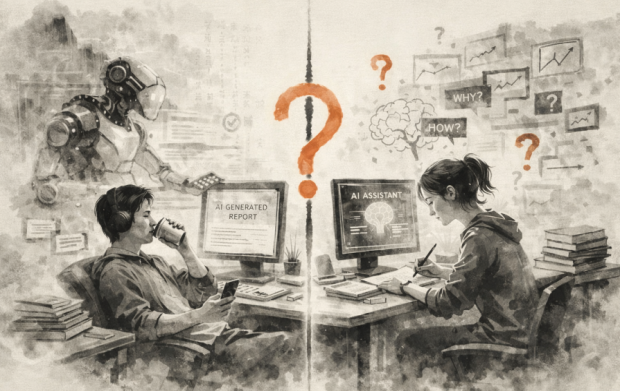

AI를 쓰는 두 부류, 나는 어디에 서 있나

미국 테크 업계의 영향력있는 투자자, 마크 큐반은 X(구 트위터)에 짧은 문장 하나를 남겼습니다. "대규모언어모델(LLM) 사용자는 크게 두 종류다. 모든 것을 배우기 위해 쓰는 사람과, 아무것도 배우지 않아도 되려고 쓰는 사람." NBA 댈러스 매버릭스의 전 구단주이자 미국의 대표적인 테크 억만장자인 그의 말치고는, 한 줄짜리 분류가 꽤 날카롭다. 그리고 불편하다. 왜냐하면 우리 대부분은 자신이 전자라고 믿지만, 실제 행동은 후자에 가깝기 때문이다. 생각해보면 도구의 역사는 언제나 이 두 유형의 긴장 위에 서 있었다. 계산기가 보급됐을 때, 어떤 학생은 수식의 구조를 더 깊이 이해하기 위해 계산기를 썼고, 어떤 학생은 구구단을 외우지 않아도 된다는 이유로 계산기를 찾았다. 인터넷이 등장했을 때도 마찬가지였다. 정보를 탐색하는 [...]

모아보기