원문 보기: What Happens When Police Use AI to Predict and Prevent Crime?

2020년 5월 미니애플리스 경찰이 비무장 흑인인 조지 플로이드를 살해한 사건을 계기로 오랫동안 미국에서 문제였던 법 집행의 편견이 드러났다.

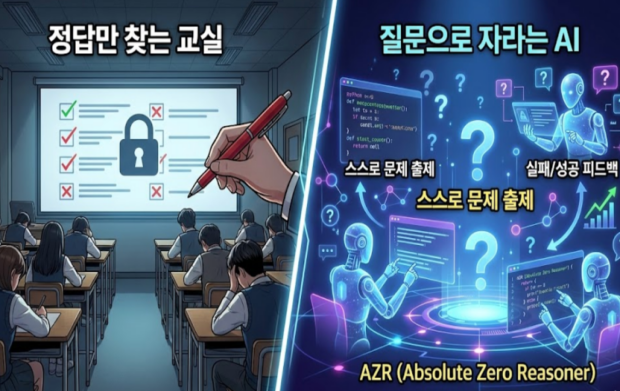

인공지능에게도 이러한 편견이 있다. 범죄에 대한 과거 정보는 머신러닝 알고리즘이 미래 범죄를 예측하는 자료로 사용될 수 있고, 이 도구 자체에 사용되는 데이터에 편견이 포함되어 있어 불평등을 강화하는 역할을 한다. 예를 들어, 신고자가 백인이든 흑인이든 흑인이 백인보다 범죄로 신고될 가능성이 더 크고 흑인 지역은 “높은 위험”으로 경찰들에게 표시된다. 하지만 이 논리는 잘못되었다. 위험 지역으로 선정된 곳에는 더 많은 경찰이 파견되고, 많은 경찰들을 본 시민들은 안전하지 않다고 느낀다. 또한, 인공지능이 과거 정보에 의존하기 때문에 일어날 수 있는 긍정적인 변화는 고려하지 않고 회생한 범죄자도 계속 처벌하고 부정적인 견해를 강화한다.

인공지능 시스템에 내재된 부정확성 또한 범죄를 예측하는 데 있어서 문제가 된다. 런던 경찰이 실시한 2018년 재판에서 얼굴 인식을 사용하여 용의자 104명의 신원을 확인하였으나 2명만 정확했다. 경찰이 용의자를 잘못 식별하게 된다면 끔찍한 일이 일어날 수 있다.

또한, 자동화된 시스템으로 법 집행 기관이 딥 러닝 도구에 점점 더 의존함에 따라 도구 자체가 권위를 갖게 되며 도구의 생산 출처도 다양해지고, 이에 따라 시스템 오류가 발생했을 때 책임을 져야 하는 사람에 대한 정보가 거의 없다. 이처럼 법 위반에 대한 알고리즘 시스템은 책임의 메커니즘 없이 정부의 의사 결정 과정에 기여하고 있다.

마지막으로, 자동화된 치안 기술은 악의적으로 사용될 수도 있다. 중국에서 안면 인식을 교통 규제 감시 이미지에 사용하면서 자국민을 추적하고 이러한 기술을 비교적 저렴하게 취득할 수 있어서 대중들이 모르게 은밀히 감시에 사용된다.

이처럼 범죄의 예측이나 치안에 사용되는 인공지능 기술의 문제에 따라 이를 통제하는 정책 초안을 작성하고, 예측 치안의 사용이 중단되는 등 무고하고 유죄한 사람을 감옥에 가두는 일이 일어나지 않도록 조심하겠다는 일부 법 집행 기관이 존재하기도 한다.

번역&요약: 정세빈

![]() 작년 영어시간에 빅데이터에 대한 글을 읽으며 ‘범죄 지도’에 대해 배운 적이 있다. 그간의 데이터를 종합해 범죄가 자주 일어나는 지역을 ‘범죄 지도’라고 하고 이곳은 경찰들이 더욱 예의주시한다. 이 글을 읽을 때만 해도 이러한 기술을 사용하면 범죄 예측과 치안에 큰 도움이 될 거라고 생각했고, 긍정적인 변화를 줄 수 있을 거라고 생각했다. 하지만 기사를 통해 치안을 강화하는 반면 인공지능이 미래가 변하지 않을 것이라고 예상하여 과거의 자료로 미래까지 평가해버리고, 미래를 과거에 고착시키는 등의 부작용을 발생시킬 수도 있다는 생각이 들었다.

작년 영어시간에 빅데이터에 대한 글을 읽으며 ‘범죄 지도’에 대해 배운 적이 있다. 그간의 데이터를 종합해 범죄가 자주 일어나는 지역을 ‘범죄 지도’라고 하고 이곳은 경찰들이 더욱 예의주시한다. 이 글을 읽을 때만 해도 이러한 기술을 사용하면 범죄 예측과 치안에 큰 도움이 될 거라고 생각했고, 긍정적인 변화를 줄 수 있을 거라고 생각했다. 하지만 기사를 통해 치안을 강화하는 반면 인공지능이 미래가 변하지 않을 것이라고 예상하여 과거의 자료로 미래까지 평가해버리고, 미래를 과거에 고착시키는 등의 부작용을 발생시킬 수도 있다는 생각이 들었다.

![]() 작년부터 계속해서 인공지능의 윤리, 차별성, 편견 등에 대한 기사를 보았다. 1년 넘게 인공지능의 편견, 특히 인종에 관련된 문제에 있어서 이슈가 있었는데 최근까지 계속해서 이런 문제가 나타나는 것이 너무 안타깝다. 애초에 인공지능에게 범죄에 대한 데이터를 학습시킬 때 인종 등의 차별이 나타날 수 있는 데이터를 제외할 수는 없는 것일까? 인공지능이 특히 법에 있어서는 완벽하게 개선이 되고 나서야 적용이 되어야할 것 같다. 계속해서 법조계에서 다양한 편견 데이터 문제가 나오고 있고 그것으로 인한 곧장 인종차별, 성차별 등은 사람들에게 향해 있다.

작년부터 계속해서 인공지능의 윤리, 차별성, 편견 등에 대한 기사를 보았다. 1년 넘게 인공지능의 편견, 특히 인종에 관련된 문제에 있어서 이슈가 있었는데 최근까지 계속해서 이런 문제가 나타나는 것이 너무 안타깝다. 애초에 인공지능에게 범죄에 대한 데이터를 학습시킬 때 인종 등의 차별이 나타날 수 있는 데이터를 제외할 수는 없는 것일까? 인공지능이 특히 법에 있어서는 완벽하게 개선이 되고 나서야 적용이 되어야할 것 같다. 계속해서 법조계에서 다양한 편견 데이터 문제가 나오고 있고 그것으로 인한 곧장 인종차별, 성차별 등은 사람들에게 향해 있다.

![]() 아무리 인공지능이 정교해지고 뛰어나다고 해도 법조계에서 활용되는 것은 너무 위험한 선택인 것 같다. 백인과 흑인을 비교했을 때도 알고리즘 상에서 큰 차별이 존재하는데 중동이나 아시아계 사람들도 마찬가지로 불이익을 받을 것이다. 물론 인간에게도 편견이 내재 되어있고 완벽한 판결을 내릴 수는 없지만, 결함이 많은 인공지능으로 판결을 내리는 것은 더 안될 일인 것 같다. 인공지능은 항상 편견과 약점을 가지고 있다는 것을 기억해야할 것이며 인공지능은 과거의 자료에만 의존하고 현재의 정책이나 사회 분위기가 반영되기 힘들다는 것도 간과해서는 안 될 것이다.

아무리 인공지능이 정교해지고 뛰어나다고 해도 법조계에서 활용되는 것은 너무 위험한 선택인 것 같다. 백인과 흑인을 비교했을 때도 알고리즘 상에서 큰 차별이 존재하는데 중동이나 아시아계 사람들도 마찬가지로 불이익을 받을 것이다. 물론 인간에게도 편견이 내재 되어있고 완벽한 판결을 내릴 수는 없지만, 결함이 많은 인공지능으로 판결을 내리는 것은 더 안될 일인 것 같다. 인공지능은 항상 편견과 약점을 가지고 있다는 것을 기억해야할 것이며 인공지능은 과거의 자료에만 의존하고 현재의 정책이나 사회 분위기가 반영되기 힘들다는 것도 간과해서는 안 될 것이다.

![]() 인공지능에 완전히 의존할 수 없는 가장 큰 이유라고 생각한다. 이런 기사들을 많이 보다 보니까 인공지능이 아이 같다는 생각이 든다. 순수하고 착한 아이 말고 철없고 솔직한 아이 말이다. 어른들은 속으로는 편견이 가득하지만 그것을 드러내지 않으려고 노력한다. 그것이 바람직하지는 않지만 함께 살아가야 할 사람으로서 갖춰야 할 최소한의 예의라고 생각한다. 하지만 아이는 본인이 생각하는 것들을 필터링 없이 다 말한다. 그런 솔직함이 좋을 때도 있지만 남에게 상처주기 쉽다. 편견을 그대로 결과로 내보낸다는 의미에서 인공지능은 아이 같다는 생각을 했다. 사실 편견 자체도 인간이 만든 것이기에 인공지능을 탓할 수 없다. 하지만 만약 인공지능을 사람처럼 사고하고 일을 하게 만들고 싶다면 사람이 사회를 살아가면서 갖추어야하는 예의와 윤리의식도 같이 가르쳐야 한다.

인공지능에 완전히 의존할 수 없는 가장 큰 이유라고 생각한다. 이런 기사들을 많이 보다 보니까 인공지능이 아이 같다는 생각이 든다. 순수하고 착한 아이 말고 철없고 솔직한 아이 말이다. 어른들은 속으로는 편견이 가득하지만 그것을 드러내지 않으려고 노력한다. 그것이 바람직하지는 않지만 함께 살아가야 할 사람으로서 갖춰야 할 최소한의 예의라고 생각한다. 하지만 아이는 본인이 생각하는 것들을 필터링 없이 다 말한다. 그런 솔직함이 좋을 때도 있지만 남에게 상처주기 쉽다. 편견을 그대로 결과로 내보낸다는 의미에서 인공지능은 아이 같다는 생각을 했다. 사실 편견 자체도 인간이 만든 것이기에 인공지능을 탓할 수 없다. 하지만 만약 인공지능을 사람처럼 사고하고 일을 하게 만들고 싶다면 사람이 사회를 살아가면서 갖추어야하는 예의와 윤리의식도 같이 가르쳐야 한다.

![]()

이런 기사를 읽을 때마다 느끼는 건데 알고리즘의 편견을 논리적이라고 믿어버리는 경우 너무 위험하다는 것입니다. 알고리즘이 데이터세트의 편견을 학습 후 오히려 편견이 강화될 수도 있고요. 만약에 알고리즘으로 나온 내가 범죄확률이 높다고 나오면 난 조심하느라고 더 착하게 살까요? 어차피 지워지지 않을 주홍글씨라며 제대로 나쁜 짓을 더 하며 살게 될까요? 궁금해지네요. 쓸데없는 호기심이….

![]()

이 기사를 읽으니 마음이 무거워집니다. 무책임한 알고리즘의 정확성이 확인되지도 않았음에도 신봉하는 사람들 거기에다 범죄예측까지… 사람들을 다치게 하는 이러한 기술들에 대한 충분한 논의가 반드시 넘쳐나야 할 것입니다.

![]()

저는 이 기사에서 ‘자동화된 시스템은 인강의 감독이 제대로 이루어지지 않는다는 것’과 오류가 발생했을 때 책임을 져야하는 사람이 불명화하고 제시되어 있지 않다는 것에 정말 소름이 돋고 화가 났어요. 기사에서 책무성 격차를 해결하지 못하면 이러한 도구의 사용을 중단되어야 한다고 하는데, 정말 동감입니다. 일부 법 집행 기관에서 이런 문제를 심각하게 받아들인다고 하니 다행이고요. 미국의 사례이지만, 우리 나라에는 이런 일들이 우리도 모르는 사이에 벌어지는 건 아닌지 모르겠습니다. 우리 언론들도 정치적인 기사 말고 요런 거 찾아내서 딴지 좀 걸어줬으면 합니다.

![]()

전에 흑인과 백인으로 나눠 범죄률을 이야기했을 때에는 머리로만 받아들였는데, 코로나로 인해 이제는 서양인과 동양인으로 나뉘어 평가받는 것은 아닌지 마음이 섬뜩해집니다. 잘못된 정보, 사람들의 편견으로 인해 또 다시 새로운 알고리즘이 만들어지겠지요.

유대인 학살, 미국 백인 경찰의 흑인 과잉 진압, 중국의 티베트와 신장 위구르인 탄압….

차별은 과거부터 현재까지 쭉 이어지고 있다.

결국 인공지능의 시작은 인간이다.

인공지능을 완성하는 과정에 부디 많은 전문가의 참여할 수 있는 환경이 되길 바라본다.