원문보기: Will Transformers Take Over Artificial Intelligence?

인공지능의 도구들 사이에서 다재다능한 트랜스포머Transformer가 나타났다. 트랜스포머는 “필요한 것은 주목뿐이다Attention Is All You Need.” 라는 논문에 처음 등장했다.

인공지능에 대한 다른 접근 방식에서 시스템은 먼저 입력 데이터의 로컬 패치에 초점을 맞춘 다음 전체에 구축한다. 예를 들어 언어 모델에서는 가까운 단어는 먼저 함께 그룹화된다. 트랜스포머가 등장하기 전에는 인공지능 언어 작업의 진행 상황이 다른 분야의 개발에 크게 뒤쳐져 있었다.

하지만 트랜스포머는 텍스트 분석 및 예측에 중점을 둔 단어 인식과 같은 애플리케이션의 선두 주자가 되었다. 이로 인해 OpenAI의 GPT-3(Generative Pre-trained Transformer 3)와 같은 도구가 등장했다. 텍사스 대학의 컴퓨터 과학자는 “트랜스포머는 보편화될 가능성을 암시하기 때문에 인기가 많다고 생각한다”고 말했다.

CNN convolutional neural network은 이미지의 픽셀에 필터를 반복적으로 적용하여 특징을 인식하는 방식으로 작동한다. 드소비츠스키Dosovitskiy는 처리 시간을 늘리지 않고 더 높은 해상도의 이미지를 나타내는 더 큰 데이터 세트를 훈련하기 위해 CNN을 확장하는 일을 하고 있었다. 그는 언어와 관련된 거의 모든 AI 작업에서 트랜스포머가 이전의 필수 도구를 대체하는 것을 보았다. 그리고 그는 트랜스포머가 단어의 큰 데이터 세트를 처리할 수 있다면 사진은 안될까? 라는 생각을 바탕으로 비전 트랜스포머Vision Transformer 또는 ViT라는 네트워크를 발표했다. 이 트랜스포머는 드소비츠스키가 예상한 것보다 훨씬 더 나은 결과인 90% 이상의 정확도로 이미지를 분류하여 획기적인 이미지 인식 대회인 이미지넷ImageNet 분류 챌린지에서 빠르게 상위권에 올랐다.

구글 연구소 마운틴 뷰 사무실의 컴퓨터 과학자인 마이트라 라구Maithra Raghu는 트랜스포머가 CNN과 같은 방식으로 이미지를 “보는”지 알고 싶었다. 라구는 기본적으로 ViT를 분리하여 이 작업을 수행했다. 그리고 궁극적으로 트랜스포머의 힘은 인코딩된 이미지 데이터를 처리하는 방식에서 나온다는 것을 알게 되었다. CNN의 접근 방식은 단일 픽셀에서 시작하여 축소하는 것과 같고 트랜스포머는 전체 이미지에 천천히 초점을 맞추는 것이다. 예를 들어 “올빼미가 다람쥐를 훔쳐보았습니다. 발톱으로 잡으려고 했으나 꼬리 끝만 얻었습니다.” 라는 문장이 있다. 단어에만 초점을 맞춘 CNN은 어려움을 겪을 수 있지만 모든 단어를 다른 모든 단어에 연결하는 트랜스포머는 올빼미가 움켜잡았고 다람쥐가 꼬리의 일부를 잃은 것을 식별할 수 있었다. 그리고 이것은 트랜스포머가 많은 종류의 데이터를 처리할 수 있음을 시사한다.

번역&요약: 유현영

![]() 트랜스포머 알고리즘이 텍스트 분석 및 예측에 큰 도움이 되고 이것이 OpenAI의 GPT-3의 기반이 되었다고 하니 신기하다. 하나의 알고리즘이 정말 많은 파생물들을 만들고 한 분야의 큰 기반이 될 수 있다는 것을 알게 되었다. ViT 네트워크를 통해 볼 수 있듯이 언어뿐만 아니라 다른 분야에서도 획기적인 혁신을 이루어 냈다는 것이 신기하고 알고리즘의 힘이 엄청난 것 같다는 생각이 들었다.

트랜스포머 알고리즘이 텍스트 분석 및 예측에 큰 도움이 되고 이것이 OpenAI의 GPT-3의 기반이 되었다고 하니 신기하다. 하나의 알고리즘이 정말 많은 파생물들을 만들고 한 분야의 큰 기반이 될 수 있다는 것을 알게 되었다. ViT 네트워크를 통해 볼 수 있듯이 언어뿐만 아니라 다른 분야에서도 획기적인 혁신을 이루어 냈다는 것이 신기하고 알고리즘의 힘이 엄청난 것 같다는 생각이 들었다.

![]() 기사를 이해하기에는 트랜스포머에 대해 알고 있는 정보가 부족한 것 같아서 관련 내용들을 찾아보았다. 트랜스포머는 인공신경망 알고리즘 중 하나로 `셀프 어텐션`(Self-Attention)이라 불리는 방식을 사용한다고 한다. 문장 전체를 병렬구조로 번역해 멀리 있는 단어까지도 연관성을 만들어 번역하는데, 이 점이 AI 딥러닝 학습 시 언어 이해 능력을 높였다고 한다. GPT-3와 같은 도구도 평소에 기사를 읽으며 자주 등장하였지만, 그 기반 기술이 트랜스포머라는 사실은 전혀 모르고 있었다. 깊이 있게 알아가야 할 정보들이 매우 많다는 것을 다시 한번 느꼈다.

기사를 이해하기에는 트랜스포머에 대해 알고 있는 정보가 부족한 것 같아서 관련 내용들을 찾아보았다. 트랜스포머는 인공신경망 알고리즘 중 하나로 `셀프 어텐션`(Self-Attention)이라 불리는 방식을 사용한다고 한다. 문장 전체를 병렬구조로 번역해 멀리 있는 단어까지도 연관성을 만들어 번역하는데, 이 점이 AI 딥러닝 학습 시 언어 이해 능력을 높였다고 한다. GPT-3와 같은 도구도 평소에 기사를 읽으며 자주 등장하였지만, 그 기반 기술이 트랜스포머라는 사실은 전혀 모르고 있었다. 깊이 있게 알아가야 할 정보들이 매우 많다는 것을 다시 한번 느꼈다.

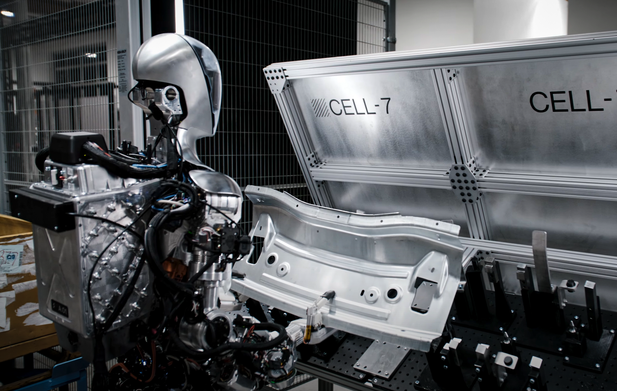

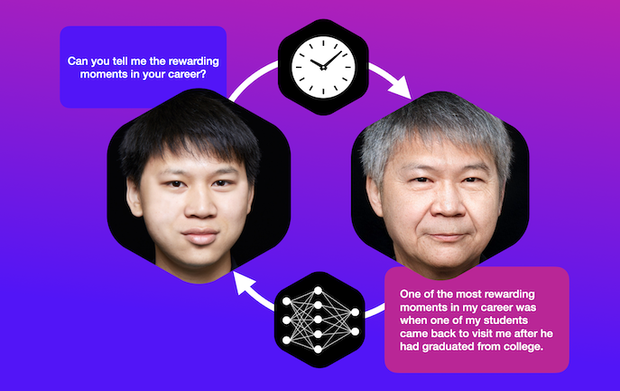

![]() 언어에서 이미지에 이르기까지 나에게는 생소한 개념인 트랜스포머가 인공지능의 발전에 큰 기여를 할 수 있는 기술이라니, 아직 인공지능 공부에 대한 갈 길이 참 멀다고 느껴진다. 트랜스포머와 CNN의 차이, 20만명 이상의 유명인의 얼굴을 훈련했을 때 적당한 해상도로 새로운 얼굴 이미지를 합성한 이중 트랜스포머 네트워크까지 트랜스포머는 혁신적인 새로운 도구가 될 가능성이 커지고 있지만 그 교육 비용이 엄청나며 CNN과 함께 사용될 가능성이 크다고 한다.

언어에서 이미지에 이르기까지 나에게는 생소한 개념인 트랜스포머가 인공지능의 발전에 큰 기여를 할 수 있는 기술이라니, 아직 인공지능 공부에 대한 갈 길이 참 멀다고 느껴진다. 트랜스포머와 CNN의 차이, 20만명 이상의 유명인의 얼굴을 훈련했을 때 적당한 해상도로 새로운 얼굴 이미지를 합성한 이중 트랜스포머 네트워크까지 트랜스포머는 혁신적인 새로운 도구가 될 가능성이 커지고 있지만 그 교육 비용이 엄청나며 CNN과 함께 사용될 가능성이 크다고 한다.

![]()

“트랜스포머는 `전체 이미지에 천천히 초점을 맞추는 것`이다. 단어에만 초점을 맞춘 CNN은 어려움을 겪을 수 있지만 모든 단어를 다른 모든 단어에 연결하는 변환기는 현상 전체의 흐름을 식별할 수 있다. 이것은 변환기가 많은 종류의 데이터를 처리할 수 있음을 시사한다.”

그냥 기사 볼 때는 이해하기 어려웠는데, 정리된 글을 읽으니 의미 전달이 잘 되네요. 인공지능의 글이 정말 자연스러워지고 진짜 사람 같아요. 그냥 대충 보고 넘기는 사람보다 오히려 정교해 보이고요. 발전속도가 아주 놀랍습니다!

![]()

정말 어려워서 요약내용과 기사를 여러 번 읽어보았습니다, 일단 이런 깊은 내용의 기사를 읽고 생각해보는 퀸텟 멤버에 존경심을 표합니다. 그리고 트랜스포머가 모든 단어와 모든 단어를 연결한다는 부분이 그림, 예시와 함께 보여보니 이해가 되네요. 덕분에 이름만 들어왔던 인공지능의 작용 기전을 조금이나마 알게 되었습니다

![]()

정말 어려운 기사네요! ㅠㅠ 처음에 읽을 때 눈에 안 들어와서 포기하고, 이제야 다시 집중하고 읽어보았어요. 초반에는 어느 정도 읽히다가 중간 넘어서면서 막 섞어지는데~~ ㅠㅠ 너무 괴로웠어요. 현영양의 요약 글을 다시 읽어보고! 5%정도는 이해한 거 같네요! 암튼, 트랜스포머 덕분에 인공지능 언어 작업의 분야가 크게 발전하게 되었고, 우리가 익숙하게 들어온 GPT도 등장하게 되었다. 저는 여기까지! 이 정도면 5%는 되죠? ^^;;;;

![[번역] 오늘날의 생성 AI 문제점의 원인이 되고 있는 토큰](https://datacdn.soyo.or.kr/wcont/uploads/2024/07/12102439/%E1%84%90%E1%85%A9%E1%84%8F%E1%85%B3%E1%86%AB%E1%84%82%E1%85%A1%E1%84%8B%E1%85%B5%E1%84%8C%E1%85%A5_620.png)

![[번역] 점과 점 연결하기: AI가 웹을 먹어치우고 있다.](https://datacdn.soyo.or.kr/wcont/uploads/2024/07/06142422/%E1%84%82%E1%85%A6%E1%84%90%E1%85%B3%E1%84%8B%E1%85%AF%E1%84%8F%E1%85%B3_620.png)

![[번역] 디지털 시대의 언어 변화](https://datacdn.soyo.or.kr/wcont/uploads/2024/06/14103144/%E1%84%82%E1%85%A1_%E1%84%8B%E1%85%A5%E1%86%AB%E1%84%8B%E1%85%A5_620.png)

![[독서 3] ‘책 읽기’가 아니라 ‘읽기’부터](https://datacdn.soyo.or.kr/wcont/uploads/2024/06/14102017/%E1%84%80%E1%85%A1_1_620.jpg)

![[AI와 교육] 학습에 다양하게 챗봇을 활용하고 있는 미국의 중고등학생](https://datacdn.soyo.or.kr/wcont/uploads/2024/06/07152728/%E1%84%80%E1%85%A3%E1%86%BC_0.png)

역시 어려운 기사여도 여러 번 보니 조금 더 의미가 와 닿네요. 이런 글을 퀸텟을 통하지 않았다면 접근할 일이 단 1%라도 있었을까 싶어요.

한 번 더 읽고, 조금 더 찾아보고 개념을 조금 더 알아갑니다.

[AI의 딥 러닝 학습의 인공신경망 알고리즘은 크게 ▲합성곱 신경망(CNN) ▲순환 신경망(RNN) ▲트랜스포머(Transformer) 3가지로 나뉜다.]

[트랜스포머는 RNN을 사용하지 않지만, 기존의 seq2seq처럼 인코더에서 입력 시퀀스를 입력받고, 디코더에서 출력 시퀀스를 출력하는 인코더-디코더 구조를 유지합니다. 다른 점은 인코더와 디코더라는 단위가 N개 존재할 수 있다.](이 부분을 이미지에 놓고 보니 조금은 아…. CNN과의 차이점이 이미지로 눈에 보이네요.)

자연어처리 시 어텐션으로 전체 흐름을 더 매끄럽게 연결할 수 있다.

정확한 이해도가 아니라 다음에 보면 또 아리송하겠지만, 그래도 기사가 조금은 읽힌다는 게 좋습니다.

퀸텟멤버들의 역량에 놀랍니다. 와!!!

현영양이 내용을 잘 정리해줬는데….전 내용 이해가 어렵네요.분명 한글인데 ^^;;;

저도 어려워서 검색하며 매번 읽는 데 이렇게 열심히 올려주고 의견을 나누니 너무 좋아요~ 감사합니다.

인공지능의 성장을 따라 잡지는 못하지만 저는 하나 씩 찾아가며 알아가는 즐거움이 너무 좋아요~

조금씩이지만 갑자기 아! 하는 순간 너무 좋습니다. ㅎㅎㅎ