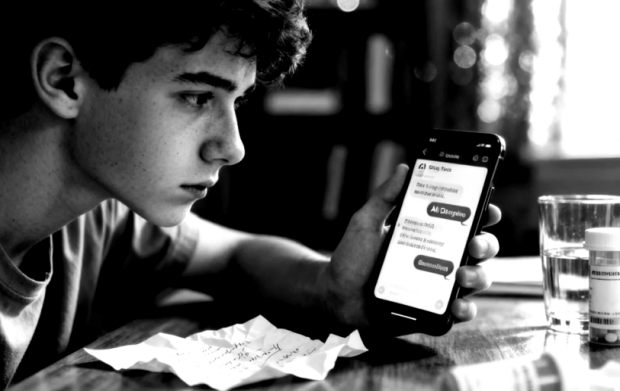

인공지능이 인간의 판단과 결정을 대신하는 것이 점점 늘어나고 있다. 대량의 데이터를 분석하고 사람의 의사판단을 지원하는 수준을 넘어서 대학의 예비 합격자를 선정하고 업무 능력을 평가하고, 심지어는 범죄 가능성까지 예측하는 등 사람을 판단하려는 시도가 이루어지고 있다.

이런 상황에서 인공지능이 내재적인 인종차별 혹은 성차별의 위험성을 지니고 있다는 전문가의 경고가 있었다. 최근의 한 조사에 의하면 대학의 예비 합격자 후보를 선정하고 은행의 대출 자격을 평가하기 위해 만들어진 프로그램이 여성과 유색인종 지원자들에게 차별적인 결과를 보이고 있는 것으로 나타났다.

책임 있는 로봇학을 위한 재단(the Foundation for Responsible Robotics)의 공동대표 노엘 샤키(Noel Sharkey) 교수는 인공지능의 발전에 중심적인 역할을 하고 있는 딥 러닝 알고리즘이 “투명하지 않아서 문제를 해결하는 것을 어렵게 한다 ”고 경고하고, 인공지능에 의한 편견을 시정하기 위해 여성들이 더 많이 IT 산업에 진출해야 할 필요가 있다고 주장한다. 그는 영국 의과대학의 합격 후보자 선정을 위해 개발된 프로그램의 프로토타입 실험 결과 여성과 유색인종에 불리한 결과가 나온 후에 이 같이 경고했다.

샤키 교수는 또 보스턴 대학의 연구진이 구글뉴스에서 수집된 텍스트를 분석하는 프로그램을 훈련시킨 인공지능의 편견을 입증한 사실을 사례로 제시하고 있다. 보스턴 대학 연구진은 인공지능에게 완전한 문장으로 “남자가 컴퓨터 프로그램이라면 여자는 무엇인가요?”라는 질문에 “주부”라고 대답했다.

사진 속의 내용을 설명할 수 있게 개발된 미국의 인공지능 플랫폼은 소셜미디어에 있는 수많은 사진을 대상으로 테스트를 진행하였다. 그 결과 부엌에 있는 한 남자를 여자로 인식하였다. 가사 일은 여자가 한다는 성역할에 대한 편견을 드러낸 것이다.

지난 해 5월에 발표된 또 다른 연구자료는 미국 법정에서 사용하고 있는 리스크 평가 프로그램이 흑인 재소자에게 불리한 결과를 보이고 있다는 것을 입증했다. 프로퍼블리카(ProPublica)에 의해 수행된 조사에 의하면 그 프로그램이 흑인 재소자가 출소 후에 범죄를 다시 저지를 확률이 더 높은 것으로 판단하는 오류를 범하고 있다는 것이다.

보건의료 정보 전문가 맥신 매킨토시(Maxine Mackintosh)는 이런 편견과 차별의 원인으로 인공지능 플랫폼의 학습을 위해 사용된 정보, 빅데이터의 왜곡에 있다고 본다. BBC와의 인터뷰에서 “빅데이터는 실제 사회를 반영하는 거울이다. 그렇기 때문에 그것은 우리 사회가 가지고 있는 편견과 불평등이 반영된 것이다”라고 설명한다.

인공지능에 의한 판단과 평가를 지지하는 사람들은 그 장점으로 속도와 정확성과 함께, 사람이 가지고 있는 편견과 차별에서 자유스럽다는 것을 강조한다. 그렇지만 현 단계에서 공정한 인공지능을 말하는 것은 시기상조이다. 인공지능을 학습시키는 우리의 현실이 공정하지 못하기 때문이다. 인공지능이 스스로 편견과 차별을 극복하는 것과 우리 사회가 공정하게 변화하는 것 중에 어느 것이 더 현실적일까?

댓글을 남겨주세요

댓글을 남기려면 로그인 해야 합니다.