현대 사회에서 인공지능(AI)의 역할이 확대되면서, 우리는 기술의 혁신과 윤리적 딜레마 사이에서 균형을 잡아야 하는 중대한 갈림길에 서 있습니다. AI라는 용어는 여전히 존재하지만, 그 의미는 종종 혼란스럽습니다. ChatGPT와 같은 대규모 언어 모델이 주목받고 있지만, 우리가 일상에서 마주치는 AI의 대부분은 여전히 알고리즘에 크게 기반을 두고 있습니다.

알고리즘은 원하는 만큼 간단하거나 복잡할 수 있는 일련의 if-then 문장입니다. 이 간단해 보이는 구조가 우리의 삶에 미치는 영향은 실로 막대합니다. 소셜 미디어 플랫폼에서 우리가 접하는 콘텐츠부터 법 집행 기관의 의사결정에 이르기까지, 알고리즘은 우리의 일상 곳곳에 스며들어 있습니다.

최근 스페인의 VioGen(Violence de Género) 시스템과 로브나 헤미드의 비극적인 사례는 AI의 윤리적 판단이 가져올 수 있는 심각한 결과를 적나라하게 보여주고 있습니다. VioGen은 2007년 스페인 내무부가 도입한 AI 기반 위험 평가 시스템으로, 가정 폭력의 위험을 예측하고 평가하기 위해 사용됩니다.

2022년 11월, 32세의 로브나 헤미드는 남편의 폭력을 피해 경찰에 도움을 요청했습니다. 경찰은 그녀에게 35개의 표준화된 질문을 했고, 그 답변을 VioGen 시스템에 입력했습니다. 이 과정에서 헤미드의 개인적 상황, 즉 그녀가 이민자이며 네 명의 어린 자녀를 둔 어머니라는 맥락은 충분히 고려되지 않았습니다. VioGen은 단순히 입력된 데이터만을 바탕으로 헤미드의 위험 수준을 “낮음”으로 평가했습니다.

이 평가 결과에 따라, 헤미드의 남편은 구금되지 않고 풀려났습니다. 그녀에게는 특별한 보호 조치도 제공되지 않았습니다. 그로부터 불과 7주 후, 최악의 시나리오가 현실이 되었습니다. 헤미드의 남편은 그녀를 잔인하게 칼로 찔러 살해한 뒤 자살했습니다. 더욱 충격적인 것은 이 끔찍한 사건이 그들의 네 자녀가 집에 있는 동안 발생했다는 점입니다.

이 사례는 AI 시스템의 판단이 얼마나 치명적인 결과를 초래할 수 있는지를 여실히 보여줍니다. VioGen은 헤미드의 생명을 위협하는 긴급한 위험 신호를 포착하지 못했습니다. 시스템은 수치화된 데이터에만 의존했고, 피해자의 두려움, 가해자의 행동 패턴, 문화적 맥락 등 정성적이고 미묘한 요소들을 제대로 고려하지 못했습니다.

더욱 우려되는 점은 헤미드의 사례가 단순한 예외가 아니라는 것입니다. 통계에 따르면, VioGen이 평가한 여성 중 최대 14%가 이후 실제로 피해를 입었습니다. 또한, VioGen이 관여한 여성 살인 사건 98건을 사법적으로 검토한 결과, 그 중 56%가 알고리즘에 의해 낮거나 최소한의 위험으로 판단되었다는 충격적인 사실이 밝혀졌습니다.

물론, 인간이 시스템을 무시할 수 있다는 주장이 있습니다. 스페인에서 경찰은 VioGén의 결론을 거부할 수 있다고 배웠습니다. 그러나 95%의 경우 VioGén의 결정이 수용됩니다. 이는 경찰이 VioGén에게 양보하는 것이 더 쉽고, 여성이 피해를 입으면 알고리즘이 책임을 져야 한다는 인식 때문일 것입니다.

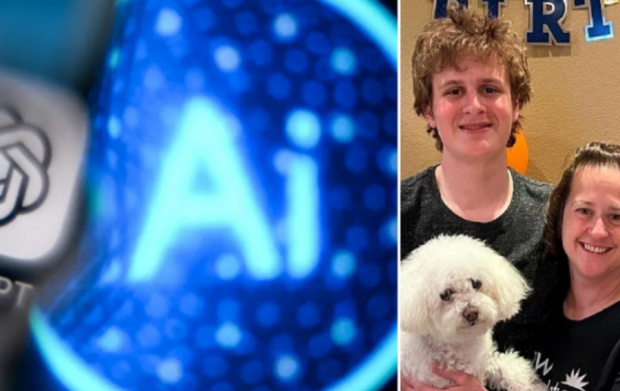

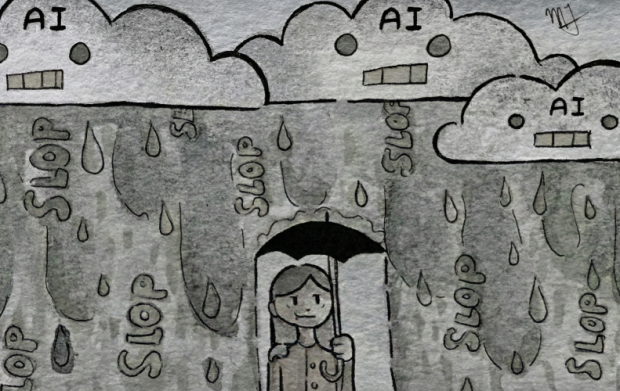

AI 알고리즘의 사용은 소셜 미디어 플랫폼에서도 유사한 문제를 야기하고 있습니다. 최근 실험에서 기자들이 새로운 페이스북 계정을 만들었을 때, 어떤 상호작용도 없었음에도 불구하고 3개월 만에 매우 성차별적이고 여성혐오적인 이미지가 피드에 나타났습니다. 이는 소셜 미디어에 슬픔을 표현한 영국의 젊은 소녀 몰리 러셀의 비극적인 사례를 떠올리게 합니다. 소셜 미디어 알고리즘에 의해 점점 더 극단적인 자해 영상이 제공되다가 결국 그녀가 자살한 사건입니다.

우리는 AI와 알고리즘의 사용이 가져오는 편의성과 효율성에 매료되어 그 위험성을 간과하고 있습니다. 특히 정부 기관에서 AI의 사용이 증가하면서, 우리는 도덕적, 윤리적 판단을 기계에 아웃소싱하고 있습니다. 이는 인간의 책임을 회피하고 알고리즘을 편리한 희생양으로 삼는 위험한 관행으로 이어지고 있습니다.

AI 시스템의 불투명성도 큰 문제입니다. VioGen의 경우, 정부는 시스템의 효과에 대한 포괄적인 데이터를 공개하지 않고 외부 감사를 거부했습니다. 이는 AI의 결정 과정을 블랙박스로 만들어, 책임 소재를 불분명하게 만듭니다.

우리는 AI와 인간 사회의 통합 과정에서 발생하는 미묘하고 덜 눈에 띄는 위험에 주목해야 합니다. AI는 우리의 보조 도구로 사용되어야 하며, 중요한 윤리적 결정을 전적으로 AI에 맡겨서는 안 됩니다. 인간의 판단, 공감, 그리고 맥락에 대한 이해는 여전히 불가체한 가치를 지니고 있습니다.

앞으로 우리는 AI 시스템의 투명성과 책임성을 높이기 위한 노력을 기울여야 합니다. 동시에, AI의 결정을 맹신하지 않고 인간의 판단을 존중하는 균형 잡힌 접근이 필요합니다. 우리의 목표는 기술의 혜택을 누리면서도 인간의 존엄성과 안전을 지키는 것이어야 합니다.

로브나 헤미드와 몰리 러셀의 비극이 우리에게 주는 교훈을 간과해서는 안 됩니다. AI의 윤리적 판단에 대한 맹신은 인간의 생명을 위협할 수 있습니다. 우리는 기술의 발전과 함께 인간성의 가치를 재확인하고, 더 나은 미래를 위해 AI를 책임감 있게 활용하는 방법을 모색해야 할 것입니다. 어떤 사람들은 AI를 종말론적 관점에서 봅니다. 하지만 진정한 위험은 우리가 눈을 돌리는 사이에 더 많은 로브나 헤미드와 몰리 러셀이 생길 수 있다는 것입니다. 이제는 우리가 기술을 통제하고 있는지, 아니면 기술이 우리를 통제하고 있는지 진지하게 성찰해야 할 때입니다.

댓글을 남겨주세요

댓글을 남기려면 로그인 해야 합니다.